.

Japanese Only

研究内容

更新日: 2015年01月01日

ホーム

ホーム

研究内容

研究内容

研究業績

研究業績

イベント

イベント

メンバー

メンバー

ロボット

ロボット

卒業生

卒業生

講義

講義

配属希望

配属希望

アクセス

アクセス

リンク

リンク

研究の概要

ロボットやマルチメディア情報処理に関する研究を行っています.

研究を進めるための基礎となるテクニックは,

- 画像処理:人間の目の働きをコンピュータで実現する技術

- 人工知能:推論・判断などの知的な機能をコンピュータで人工的に実現する技術

- メカトロニクス:機械工学と電子工学を統合し,機械の制御などをコンピュータで行う技術

などです.

研究内容の概要につきましては,

などを御覧下さい.

使用しているロボットやセンサなどの実験装置につきましては,

を御覧下さい.

これまでの研究テーマは以下の通りです.現在は中断している研究テーマも,そのテーマを希望する学生が配属されましたら,再開するかどうか相談します.

興味をお持ちの方,更に詳しい内容を知りたい方はメール等でご連絡下さい.事前に予約をして日程調整を行えば,確実に研究室を見学して頂けます.アポイントなしでの見学も歓迎致しますが,出張・講義・ゼミなどの場合には対応することができませんので予めご了承下さい.

内容

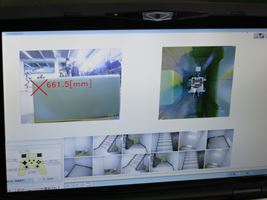

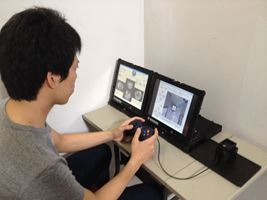

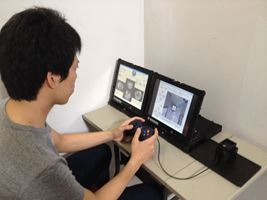

移動ロボットを遠隔操作する際,ロボットに搭載された複数のカメラの情報を効率的にオペレータに提示することが重要です.

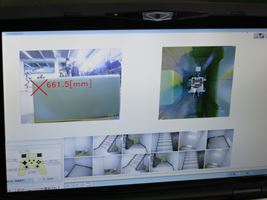

そこで,ロボットに横向きに取り付けた4台のカメラの映像に対して画像処理を施し,あたかもロボットの真上に取り付けたカメラから見たような俯瞰画像を生成し,オペレータに提示する技術を開発しました.

|

|

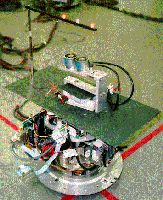

| 前後左右方向にカメラを取り付けた全方向移動ロボット |

左図:4台のカメラの映像.右図:生成した俯瞰画像 |

|

本手法は,NEDOの災害対策ロボットプロジェクトで東芝と共同開発したロボットに搭載し,福島原発などでの作業に活用することを目指しています.

|

|

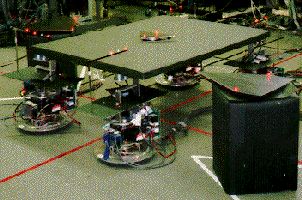

| NEDOプロジェクトで開発した水陸両用移動ロボット |

移動ロボットの遠隔操作画面(東芝と共同開発) |

|

|

|

|

|

| 水陸両用移動ロボット |

遠隔操作画面 |

4台のカメラの映像 |

生成した俯瞰画像 |

|

データ

内容

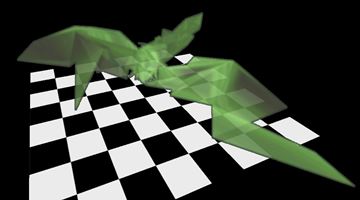

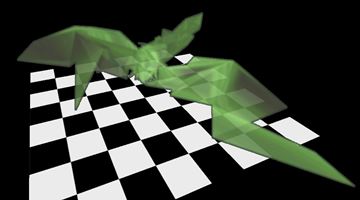

米国アラスカに天空に向けて設置した2台の魚眼カメラで撮影した画像を用いて,オーロラの3次元計測を行います.

2枚の画像からオーロラの形状を知ることができました.

|

|

|

| オーロラ画像1 |

オーロラ画像2 |

3次元計測・可視化結果 |

データ

- 論文: A-044, B-089, E-191, E-231(番号は研究業績のページの論文番号を表しています)

- 受賞: H-31(Nominated as Candidates for IWAIT2013 Best Paper Award)

- 担当: 久保尭之君(東京大学2013年度学部卒)

森祥樹君(静岡大学2011年度学部卒,2013年度修士了)ほか

内容

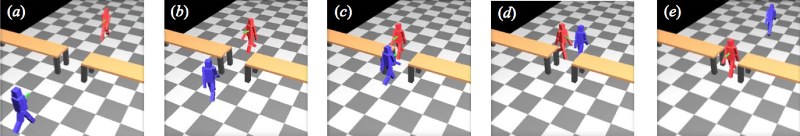

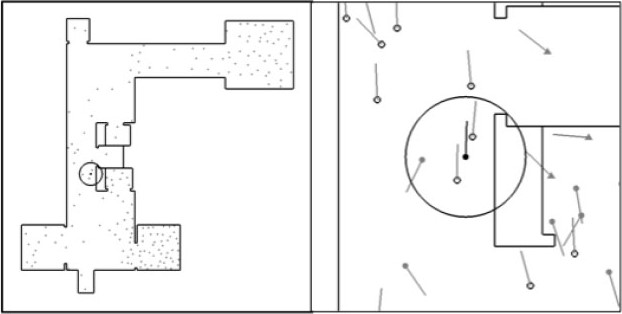

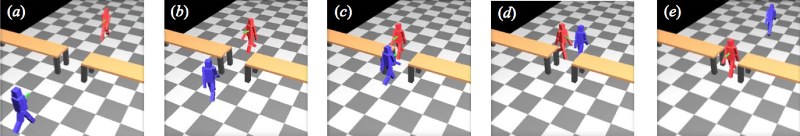

歩行者が存在する環境において,歩行者や障害物にぶつからないように移動するためのナビゲーション手法を提案しました.

まず,歩行者の行動を再現するモデルを構築し,歩行者の行動を忠実にシミュレーションできる手法を構築しました.

|

| 歩行者の行動のモデル化:狭い場所で道を譲る行動の発現 |

|

そして,移動ロボットが歩行者の意図を推定する方法,歩行者についていくことにより目的地点までスムーズに移動する方法などを構築し,多数の歩行者が存在する環境においてスムーズにロボットを動作させることができました.

|

移動ロボットのナビゲーション

左図:ロボットが移動している様子.右図:ロボット周囲の拡大図 |

|

データ

- 論文: A-39,A-41,B-91,E-179,E-194,E-202,E-212(番号は研究業績のページの論文番号を表しています)

- 担当: レーフックダイ君(東京大学2011年度学部卒)

濱崎峻資君(東京大学2012年度修士了)

熊原渉君(東京大学2012年度修士了)

伊部直樹君(東京大学2012年度学部卒)ほか

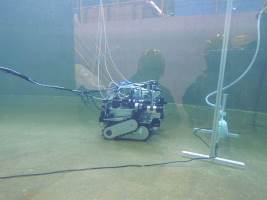

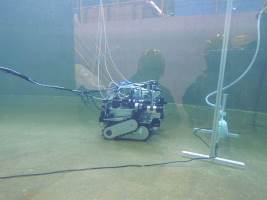

内容

水中にある物体は光の屈折により像が歪みむため(左図),正しい位置や大きさを計測することができません.そこで,光の屈折を考慮した物体センシング手法を提案しました.

応用先として,災害対策ロボット用のセンシング技術としての活用を目指しています.

|

|

| 水陸両用ロボット(NEDOプロジェクトで東芝と研究開発) |

ロボットによる水中センシングの様子 |

|

データ

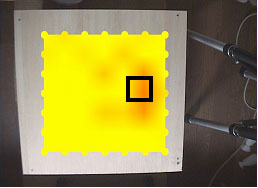

内容

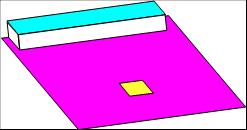

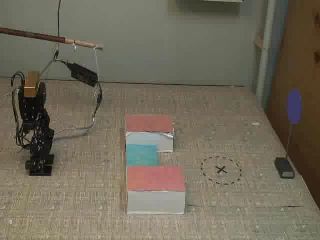

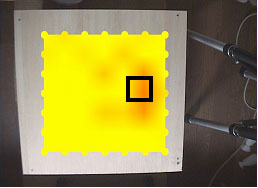

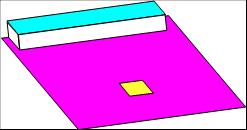

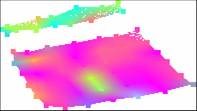

物体の内部構造などは,目で見ても分かりません.この場合には,叩いた音で判定する打音検査が有効です.そこで,画像から叩いた場所,音響信号から内部構造をそれぞれ解析する方法を提案しました.

上図においては,黒色の四角形で囲まれた部分が他の場所より分厚くなっています.実験の結果,分厚い場所を正しく判定することができました.

また,下図においては実際の様子(色:厚みを表す,形:外部形状を現す)と打音検査結果が一致することも確認できます.

|

|

| 打音検査の結果 |

(赤色:分厚い部分,黄色:薄い部分) |

|

|

| 実際の様子 |

打音検査結果 |

データ

- 論文: A-17,A-27,B-20,E-23,E-35

- 受賞: H-8(日本機械学会ロボティクス・メカトロニクス部門ベストプレゼンテーション表彰)

- 担当: 藤井浩光君(東京大学2015年度博士了予定)

原隆浩君(静岡大学2003年度修士了)ほか

内容

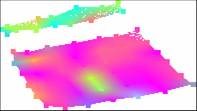

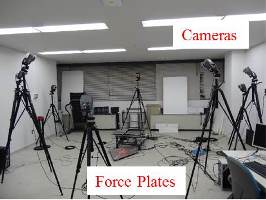

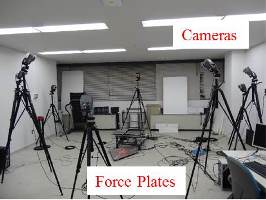

ロボット技術を用いた高齢者のリハビリに関する研究開発を行っています.

歩行動作,起立動作(立ち上がる動作),投擲動作(物を投げる動作)などに関して,モーションキャプチャ(動きをリアルタイムに計測する装置),床反力計(両足が床面に加える力を計測する装置),筋電系(筋肉の活動を計測する装置)などを用いて動作の計測を行い,その結果を解析することで,リハビリに活用することを目的としています.

|

|

|

| 人間動作の計測 |

人間動作の計測装置 |

人間動作の解析シミュレーション |

|

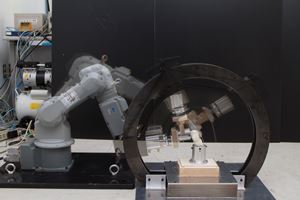

| ロボット技術を用いた膝関節模型による膝負荷計測 |

データ

- 論文: A-047,A-049,B-080,B-093,B-094(番号は研究業績のページの論文番号を表しています)

- 担当: 石川雄己君(東京大学2012年度修士了,2015年度博士了予定)

安琪君(東京大学2014年度博士了予定)

林鐘勳君(東京大学2014年度修士了)

花谷耕平君(東京大学2013年度学部卒)

中川純希君(東京大学2012年度学部卒)ほか

内容

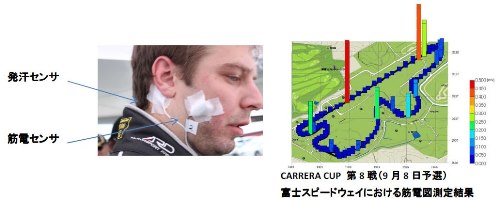

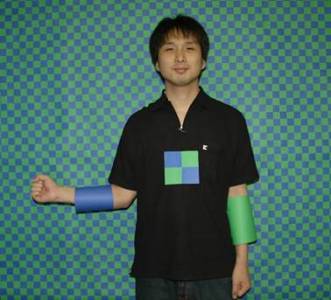

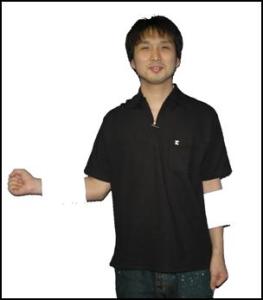

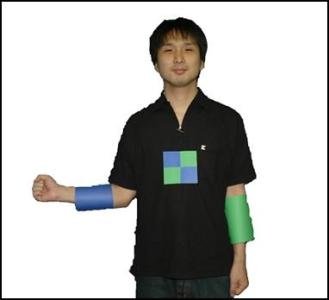

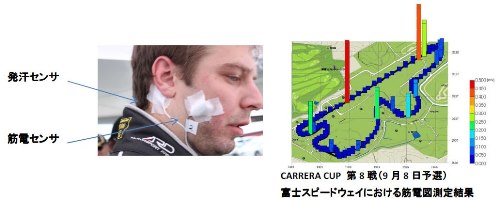

使い易いロボットのヒューマンインタフェースを開発する上で,操作者である人間について知り,脳の生理的状態や構造を考慮することは重要です.

本研究では「運動主体感(Sense of Agency)」(行為を行っているのはまさに自分自身であるという感覚)や「身体(自己)所有感(Sense of Ownership)」(この身体はまさに自分のものであるという感覚)に注目して研究を進めています.

身体所有感が外界の対象に拡張する現象の顕著な例の1つとして,ラバーハンド錯覚(RHI: Rubber hand Illusion)と呼ばれるものがあります.左上図に示すように,自分の視界から隠された本物の手と,目の前に置かれたラバー(フェイク)ハンドに絵筆等で一定時間(約2~20分程度)時間的・空間的に同期した触刺激を与え続けると,ラバーハンド上に触刺激を知覚するようになる錯覚現象です.この錯覚現象を調べることで,脳の仕組みの解明を目指しています.

また,レース中のカーレーサーの生理指標を計測する研究にも取り組んでいます(右上図,下図).

|

|

| ラバーハンド錯覚 |

カーレーサーの計測 |

|

|

カーレーサーの計測

(http://www.gsport.co.jp/img/pdf/press_releases20121120.pdfより抜粋) |

|

データ

内容

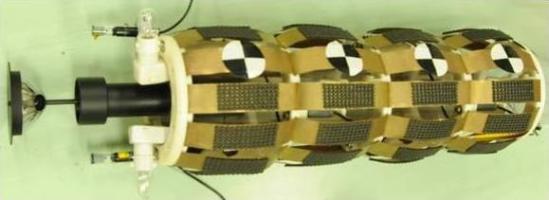

全方位カメラは,周囲360度すべての方向を同時に見ることができる広視野カメラです(下図参照).

|

|

| 全方位カメラ |

全方位画像 |

全方位カメラを移動ロボットに搭載して,周囲環境のセンシングを行う研究を行っています.

環境中の物体の3次元位置を計測したりテクスチャを貼り付けたりして,3次元地図を生成します.

|

|

|

| 単眼初号機ロボット |

単眼2号機ロボット |

ステレオ初号機ロボット |

|

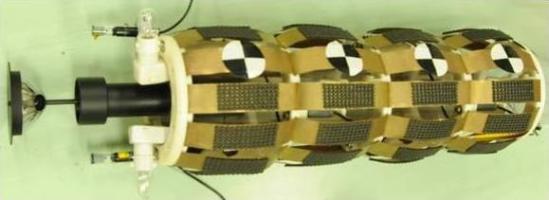

| ミミズ初号機ロボット(中央大中村太郎准教授と共同研究) |

|

|

| 屋外環境計測結果 |

テクスチャマッピング結果 |

データ

- 論文: A-22,A-28,A-29,A-30,A-35,A-37,B-39,B-51,B-55,B-59,E-73,E-82,E-91,E-137,E-147ほか

- 受賞: H-15(AISM2008 Best Student Paper Award)

H-18(IEEE Robotics and Automation Society Japan Chapter Young Award)

H-21(2010年度精密工学会秋季大会 ベストポスタープレゼンテーション賞)

- 担当: 岩滝宗一君(2013年度学部卒,2015年度修士了予定)

渡辺和史君(静岡大学2010年度学部卒,2012年度修士了)

川西亮輔君(静岡大学2006年度学部卒,2008年度修士了,2011年度博士了)

石塚大輔君(静岡大学2009年度学部卒,2011年度修士了)

後藤真一君(静岡大学2009年度学部卒,2011年度修士了)

松井建樹君(静岡大学2008年度学部卒,2010年度修士了)

纐纈理志君(静岡大学2008年度学部卒,2010年度修士了)

井上渉君(静岡大学2008年度学部卒)

原田知明君(静岡大学2003年度学部卒,2005年度修士了)ほか

内容

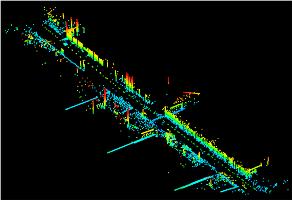

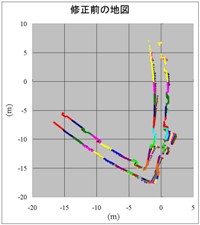

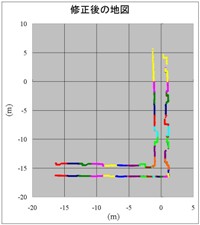

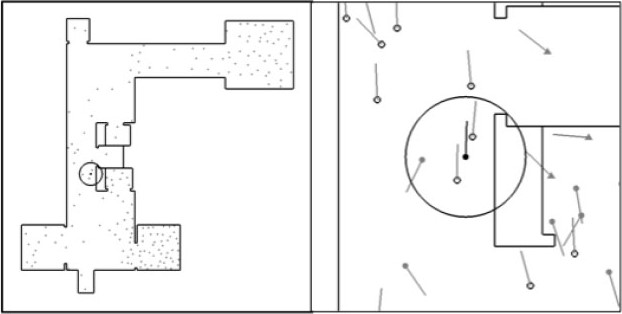

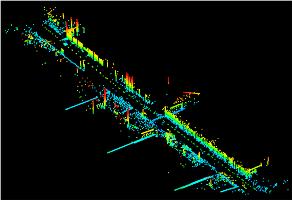

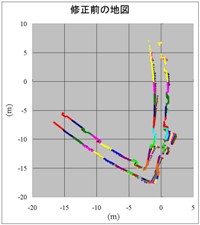

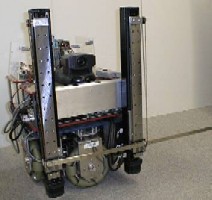

移動ロボットが作業を行うためには,環境の地図が必要です.そこで,ロボットが周囲の環境地図を自分自身で作成する方法を提案しました.

図に示す開発したロボットは,レーザを用いて障害物までの距離を正確に計測できます.どんどんロボットが移動しながら環境地図を更新していきますが,残念ながらロボットの移動精度はあまり良くありません.従って,何も考えずに地図を作成すると左図のように歪んでしまいますが,計測データから移動誤差を推定することにより右図のような正確な地図を作成することができます.

|

|

| レーザ搭載移動ロボット(初号機) |

レーザ搭載移動ロボット(2号機) |

|

|

| 修正前の地図 |

修正後の地図 |

データ

- 論文: B-28,B-50,E-53,E-68,E-96,E-110,E-120ほか

- 受賞: H-5(サマーセミナー2004優秀発表賞)

- 担当: 池勇勳君(東京大学2015年度博士了予定)

河野通隆君(東京大学2013年度学部卒)

粟井真志君(静岡大学2010年度学部卒,2012年度修士了)

清水隆史君(静岡大学2009年度学部卒,2011年度修士了)

大内隆史君(静岡大学2009年度学部卒,2011年度修士了)

岩科進也君(静岡大学2006年度学部卒,2008年度修士了)

中本琢実君(静岡大学2004年度学部卒,2006年修士了)

朝倉弘崇君(静岡大学2002年度学部卒,2004年修士了)ほか

内容

雨や雪の日には,車のフロントガラスや展望台のガラスに水滴が付いて,視野が妨害されることがあります.

そこで,複数視点からの情報を融合することや,首振りカメラの方向を変化させて複数画像を取得することにより,鮮明な画像を再生する手法を提案しました.

左と中央の図のように水滴がたくさん付いた複数画像に統計的処理をベースにした画像処理を施すことにより,左図の綺麗な画像に再生することができました.

データ

内容

これまでの技能教育は,指導者と学習者が場所と時間を共有し1対1で行われるために効率が悪いという問題がありました.一方,効率化の手段としてeラーニングシステムがありますが,これを用いて技能教育を行っても,身体動作やコツを提示することが難しいために,学習者は満足感を得られず,顧客ロイヤルティの低下を招いています.また,指導者も,学習者の上達具合や満足感などを把握しにくいために,教育スキルの獲得が困難です.

本研究では,技能において重要な身体動作の3次元計測を行うとともに,それを多視点から表示できる技術開発を行い,その計測結果から技能(コツ)を抽出する手法を構築します.これを用いることで,学習者の上達具合を定量的に評価することを可能とします.また,学習者の生理状態の計測や主観報告から,満足感を定量的に評価する手法を開発します.身体の3次元動作,学習者の上達具合や満足感を,指導者および学習者に実時間で提示することが可能なeラーニングシステムを構築することにより,指導者と学習者間で共創的に経験価値を高めることを可能にします.

これにより,学習者の満足感の向上,指導者の教育スキルの効率的獲得を可能にするとともに,技能教育サービスの効率化,顧客ロイヤルティの向上を図ります.

データ

- 担当: 中川純希君(東京大学2014年度修士了予定)

柳井香史朗君(東京大学2014年度修士了予定)ほか

内容

ステレオカメラを搭載した2足歩行ロボットが,障害物を回避しながらゴールに到着する行動を計画し,計画した内容に従って移動します.

段差やゲートなどがある複雑な環境においても,ゴールに到着できることを確認しました.

データ

内容

視覚障害者の方の目の機能のかわりをするウェアラブルビジョンシステムを研究しています.

街中では,例えば音によって信号の色を教えたり,点字によって何が書いてあるかが提示されたりしています.しかし,コンピュータやディスプレイ技術の発達により,銀行のATMに代表されるようにタッチパネルが多く使用されるようになってきました.タッチパネルは目で確認しながらボタンを押す必要があります.そこで,タッチパネルを使用する際に人間を誘導するためのステレオ型の視覚支援システムの開発を行っています.

|

|

| ウェアラブルビジョンシステム |

タッチパネル上での誘導 |

データ

既存文書の電子化(2001年4月~2012年3月)

内容

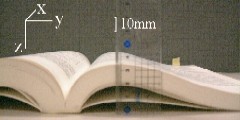

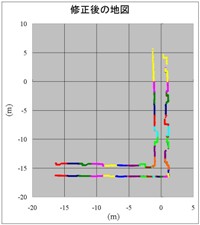

分厚い本をコピーしようとしたときに,綴じ目の部分が黒く歪んでしまったことはありませんか?

近年,様々な書籍のデジタル化が急速に進んでいますが,綴じ目が綺麗に撮影できないという問題は,文字の自動認識などの結果が悪くなり,非常に手間がかかります.

そこで,ステレオカメラにより書籍表面の映像を取得し,3次元形状を測定することにより綺麗な紙面を再生する手法を提案しました.

上図のように湾曲した書籍においても,左下図のように正確に紙面形状を計測し,その結果を利用して歪んだ画像を補正したことにより文字認識率を向上させることができました.

|

|

| 分厚い書籍 |

歪んだ画像(補正前) |

|

|

| 形状計測結果 |

補正画像 |

データ

- 論文: A-5,B-26,E-18, E-28ほか

- 受賞: H-9(サマーセミナー2006優秀発表賞)

- 担当: 大石将太君(静岡大学2009年度学部卒,2011年度修士了)

三井嘉弘君(静岡大学2009年度学部卒)

秋本廉太郎君(静岡大学2008年度学部卒)

鈴木優輔君(静岡大学2005年度学部卒,2007年度修士了)

川原子淳君(静岡大学2000年度学部卒,2002年度修士了)ほか

内容

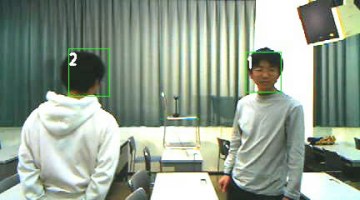

セキュリティニーズの高まりにより,カメラを用いて監視を行う機会が増加してきました.しかし監視作業に用いることができる人的資源には限りがあるため,この作業を自動化することが必要不可欠です.

そこで本研究では,カメラで撮影した画像から人間の顔を自動的に検出し,その人物を追跡する手法を提案しています.複数カメラを用いることにより,追跡している人物が後ろを向いた(顔が見えない)ときでも連続して追跡することが可能となりました.

|

|

| 研究室メンバー全員の顔を検出 |

後ろを向いた人物の追跡 |

データ

- 論文: B-49, E-89, E-102, E-105, E-111, E-113, E-118

- 担当: 伊東祐君(静岡大学2006年度学部卒,2008年度修士了)

竹内大悟君(静岡大学2008年度学部卒)

立花智哉君(静岡大学2006年度学部卒)ほか

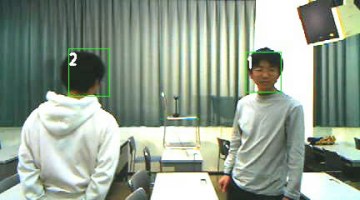

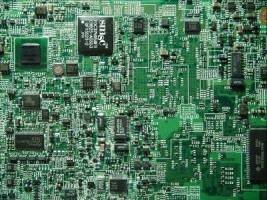

内容

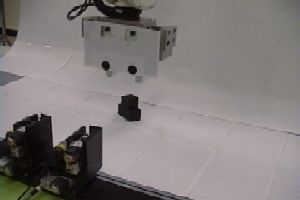

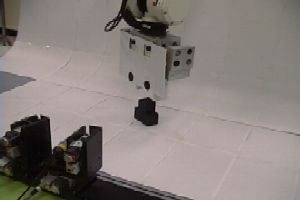

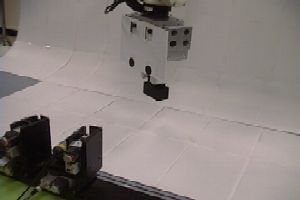

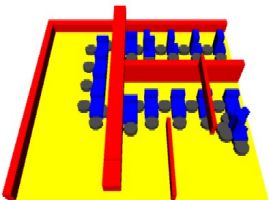

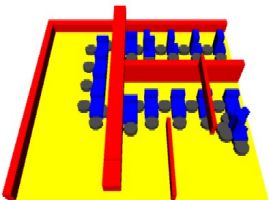

プリント配線板上に電子部品を実装するチップマウンタの動きを賢くする研究をしています.

チップマウンタのモータの性能がいくら良くても,部品をプリント配線板上に置く順番や,部品供給を行うパーツフィーダから部品を取る順番が良くないと,プリント配線板を作る時間は遅くなってしまいます.

本研究では,複数パーツ同時吸着を優先したチップマウンタ吸着動作の最適化を行い,製造時間の短縮を図ることに成功しました.

|

|

| プリント基板 |

吸着動作の最適化結果 |

データ

- 論文: B-46,B-52,E-52, E-92, E-103, E-119

- 担当: 土屋亨君(静岡大学2006年度学部卒,2008年度修士了)

杉本諭久君(静岡大学2005年度学部卒)ほか

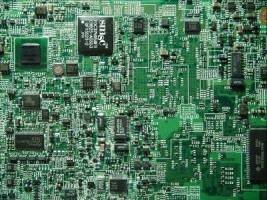

内容

青や緑の背景などを使って被写体を撮影し,別の背景と組み合わせる技術をクロマキーと言います.しかしこの方法では,背景と同じ色の服は色が抜けてしまうという欠点があります.

そこで,市松模様の背景の前で撮影することで,背景と同じ色の服を着ている場合にも対応する方法を提案しました.

また,視差のついた左眼用画像と右眼用画像を作成することで立体的に見える画像を作成する方法を提案しました.

データ

- 論文: A-11,A-20,A-23,B-13,B-17,B-53

- 受賞: H-7(映像情報メディア学会研究奨励賞)

H-13(浜松電子工学奨励会高柳研究奨励賞)

- 担当: 縣弘樹君(静岡大学2004年度学部卒,2006年度修士了)

櫻井貴之君(静岡大学2003年度学部卒)ほか

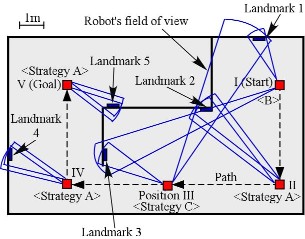

内容

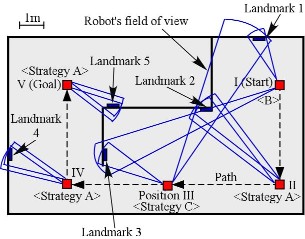

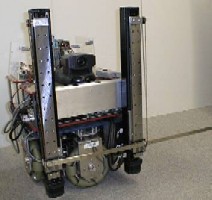

移動ロボットが作業をする上で,自分自身の位置を知ることは重要です.そこで環境中に設置されたランドマークを観測することで,自己位置同定を正確に行いながら目的地に向かう方法を提案しました.

そこでまず,人間と同じように首を振ったり両目を動かしたりすることができる移動ロボットを開発しました(左図).また右図に,迷わずに目的地に到達するためにはどのタイミングでどのランドマークを見れば良いかを計画した結果(赤色の四角形:観測地点,青色の扇形:ロボットの視野方向)を示します.

|

|

| ステレオカメラ付移動ロボット |

ナビゲーション計画結果 |

データ

- 論文: B-19,B-31,C-2,E-29, E-36ほか

- 担当: 栢分光明君(静岡大学2004年度学部卒,2006年度修士了)

藤田和俊君(静岡大学2003年度修士了)

石原智明君(静岡大学2001年度学部卒)ほか

内容

音楽にそれほど詳しくない人でも,楽器による音の違いやドレミの違いが分かると思います.

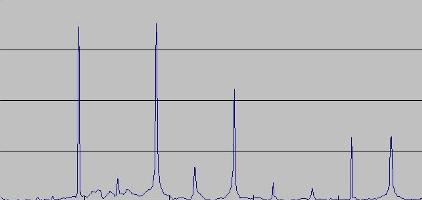

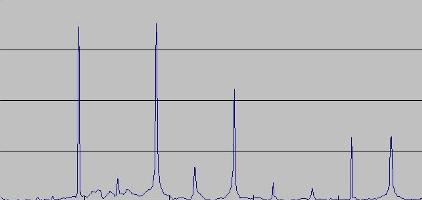

FFT(高速フーリエ変換)などを利用したりして取得した音をコンピュータで自動的に解析し,楽器の種類を同定したり,どんな和音が鳴っているのかを判別する研究を行っています.

|

|

| 管楽器の例 |

FFT結果 |

データ

- 担当: 佐竹大祐君(静岡大学2003年度学部卒)

詰石健君(静岡大学2003年度学部卒)ほか

内容

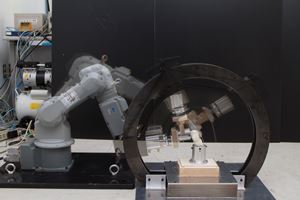

人間と同じように2つの目をロボットに持たせることにより,見ている物体の位置・姿勢を求めることができます.そこで,カメラの方向を変化させ,移動している物体に追従しつつ位置・姿勢を計測するシステムを開発しました.

ベルトコンベア上を流れる物体を流れる物体をステレオカメラで計測し,マニピュレーター(腕型ロボット)を使って掴めることを確認しました.

データ

- 論文: A-9,B-9,B-10,C-1,E-20,E-21,E-34,E-44

- 担当: 恒川法和君(静岡大学2001年度学部卒,2003年度修士了)

園原猛史君(静岡大学2002年度修士了)

松下信哉君(静岡大学2001年度修士了)ほか

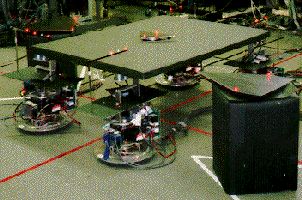

内容

これまでに開発された全方向移動ロボット(どの方向にも動けるロボット)は,ちょっとした段差も越えられないといった欠点がありました.そこで,段差を乗り越えることが可能な不整地走破能力を有する全方向移動ロボットを開発しました.

左の図は初期型ロボットで,12個も車輪がついていて,パワーで段差を登っていくタイプです.

中央の図は2号機ロボットで,車輪が9個に減ったことに加え,ロボット本体が段差にあわせて柔軟に変化して,滑らかに段差を登れます.

右の図は3号機ロボットで,車輪が7個になり,本体の柔軟性も向上しています.更にコンピュータやバッテリも搭載し,完全自律型ロボットとなっています.

データ

- 論文: A-2,A-8,B-6,E-14,E-15,E-17

- 担当: 金沢竜也君(東京理科大学)

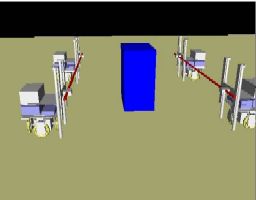

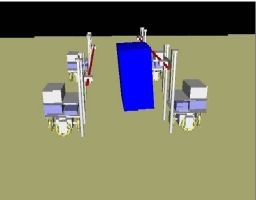

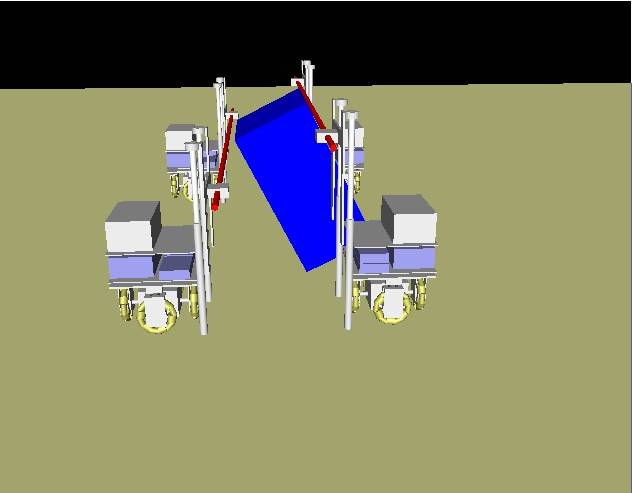

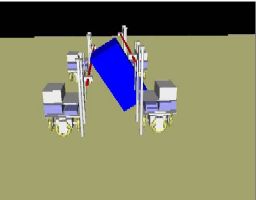

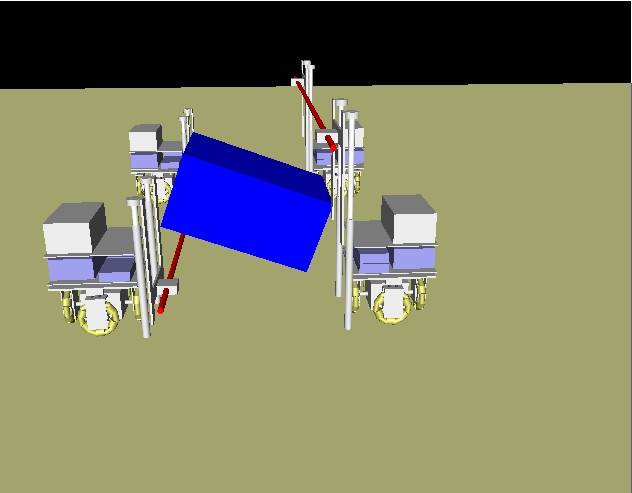

内容

移動ロボットが大きなものを運ぶときには,壁にぶつかったりしないようにしなければなりません.そこで,大きな物体の姿勢を柔軟に変化させながら,ロボットが物体を運ぶための動作計画手法を構築しました.

ここでは,物体を安全に運べること(=障害物からの距離をとる),作業効率が良いこと(=ゴールに素早く到着する),計算コストが小さいこと(コンピュータでの計算時間が短い)などを考慮しました.

左のシミュレーション結果は,青いL型の物体を黒い円形のロボットが運んでいる様子を表したものです.

また,右図のロボット(理化学研究所製全方向移動ロボットZEN)で実作業を行い,その有効性を検証しました.

|

|

| 協調物体搬送計画結果 |

全方向移動ロボット |

データ

- 論文: A-3,A-7,B-5,B-7,C-2,D-2,E-11,E-13,E-16,G-3

- 担当: 福地正樹君(東京大学2000年修士了)

内容

移動ロボットでものを操作するにはどうしたら良いか?について考えています.

そこで,安定性を保ちつつ物体の姿勢を変化させる方法をコンピュータによって計算しました.

協調物体走査計画結果は,移動ロボットが棒を使って,大きなものの姿勢をかえている様子です.

データ

- 論文: A-1,A-7,B-4,C-2,D-1,D-2,E-9,E-10,E-12,G-3

- 担当: 河野功君(東京大学1999年学部卒)

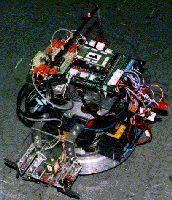

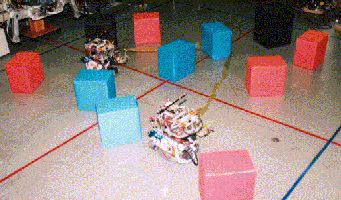

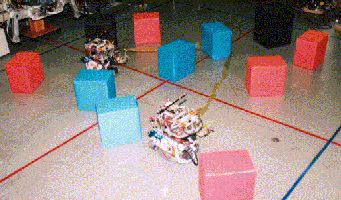

内容

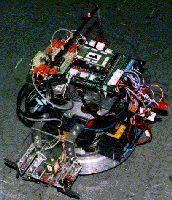

人間も道具を使って作業するように,移動ロボットも道具を使って作業した方が良いのではないか?という思いから研究を始めました.

左図が開発した移動ロボットです.自分で考え,自分で行動できるように,頭脳(コンピュータ)・電源(バッテリ)を搭載しています.各ロボットは,有線で他のロボットと通信しながらお互いの情報を共有することができます.また,道具を持つためのハンド(簡単な把持機構)を持っており,道具を取り扱うことが可能です.

中央の図は,移動ロボットが棒を道具として用いて,整頓作業(たくさんあるものの位置・姿勢をそろえる作業)を行っている様子です.

右図は,移動ロボットが紐を道具として用いて,仕分け作業(赤い箱と青い箱を分けて運ぶ作業)を行っている様子です.

|

|

|

| 移動ロボットの概観 |

棒を用いた整頓作業の様子 |

紐を用いた仕分け作業の様子 |

データ

- 論文: B-2,E-2,E-3,E-6,E-8,G-2

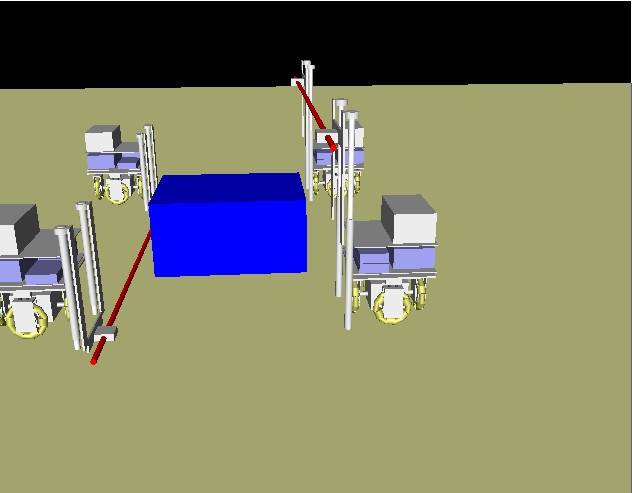

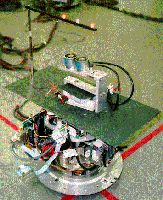

内容

人が大きいものや重いものを運ぶときには,御神輿かつぎのように,大勢で協力します.それは,移動ロボットのときも一緒だと思います.

というわけで,ロボットが障害物を避けつつ,協力して重いものを運ぶ研究をしました.

左図は,移動ロボットです.

右図は,4台の移動ロボットが大きなものを運んでいる様子です.ロボットや障害物にはLEDがつけてあって(赤く光っているところ),天井にあるカメラで見て位置・姿勢が分かるようになっています.

|

|

| 移動ロボットの概観 |

協調搬送の様子 |

データ

ホーム

ホーム

研究内容

研究内容

研究業績

研究業績

イベント

イベント

メンバー

メンバー

ロボット

ロボット

卒業生

卒業生

講義

講義

配属希望

配属希望

アクセス

アクセス

リンク

リンク

Copyright © 2011-2015 Yamashita Laboratory All Rights Reserved.